Por Nubbitel

marzo 21, 2022

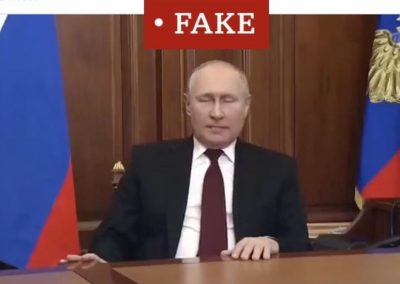

La semana pasada veíamos a Vladimir Putin declarando la paz. El quid de la cuestión es que era mentira. También vimos a un falso Volodymr Zelensky solicitando a los ucranianos que depusieran las armas. No estamos diciendo nada nuevo si hablamos de que una importante batalla de esta guerra en la que están puestas todas las miradas, se está librando en el ámbito de la desinformación y de la propaganda. Sin embargo, estos días se ha puesto sobre la mesa una tecnología que lleva tiempo circulando, concretamente aquella que se conoce como Deep fake. Porque, como te estamos contando, esto no es nuevo. Por ejemplo, así a bote pronto, me viene a la cabeza la imagen de Lola Flores animándonos a beber una cerveza “con acento”, o a Carrie Fisher interpretando a la princesa Leia en Star Wars, desgraciadamente ya “desde el otro lado de la Fuerza”. Ya estamos conviviendo día a día con esta tecnología, pero es ahora cuando también está empezando a extenderse la alerta sobre los peligros que conlleva.

Cada vez es más difícil distingur entre imágenes reales e imágenes «fake». Son tecnologías basadas en Inteligencia Artificial y las imágenes sintéticas que producen generan más confianza que las de los rostros reales.

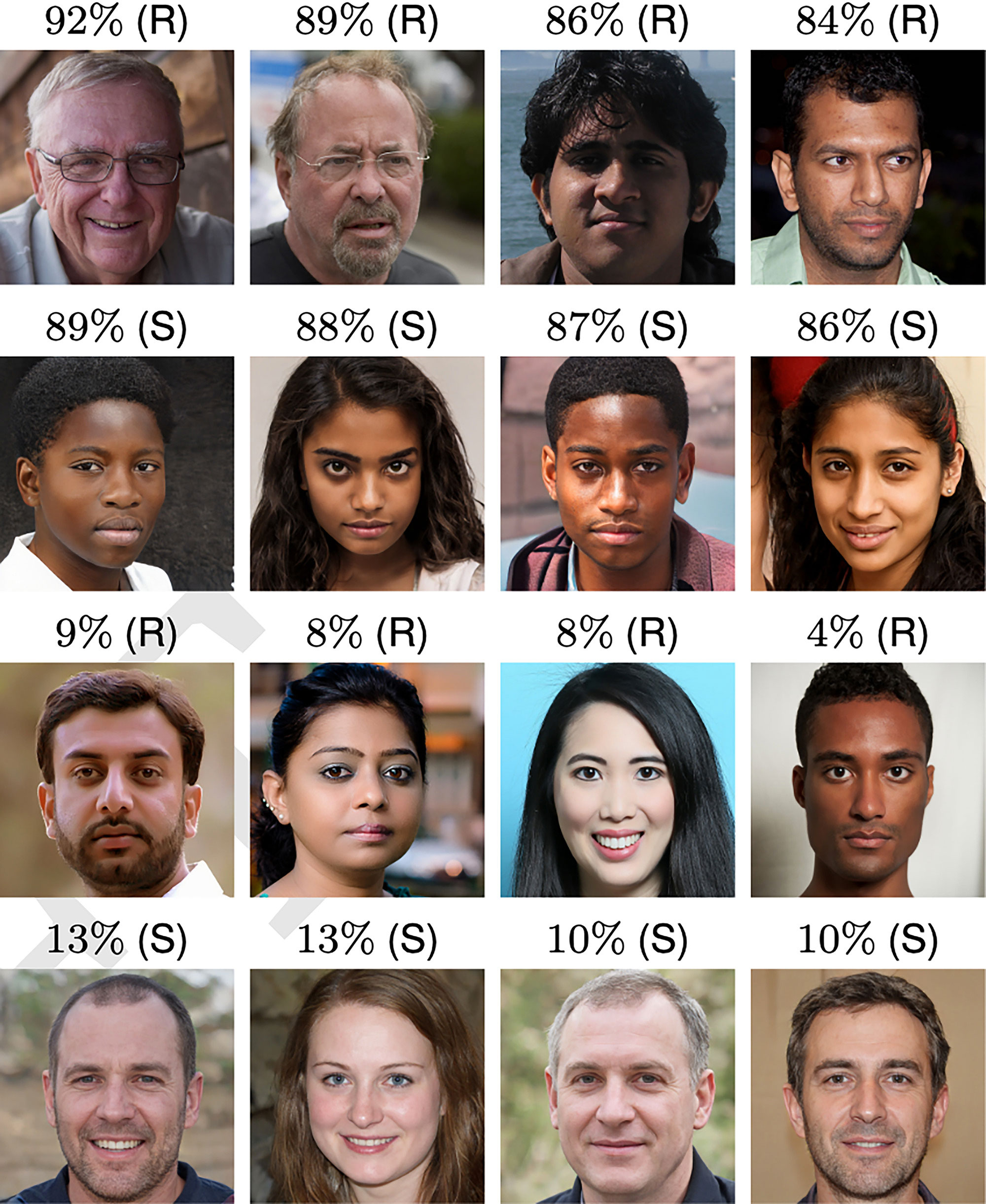

Estos días, hemos leído en numerosos medios acerca de un estudio realizado por la Dra. Sophie Nightingale de la Universidad Lancaster del Reino Unido y el Profesor Hany Farid de la Universidad de Berkeley en California, realizado para analizar la capacidad que tenemos para reconocer estas imágenes fake y el resultado del mismo ha sido, cuanto menos, inquietante. Resulta que nos damos cuenta del engaño en menos del 50% de las ocasiones. O sea, una de cada dos nos la cuelan. Tendríamos más posibilidades haciéndolo al azar, a cara o cruz, por ejemplo. En ese mismo estudio, los observadores fueron un poco más certeros, una vez que se les dieron unas pinceladas sobre los puntos y detalles en los que deberían fijarse para determinar la autenticidad de las imágenes. Pero sólo un poco más, no llegaba al 60%. Quizá lo más increíble del estudio es que, tras analizar 128 fotografías retrato, los participantes otorgaron un grado de confianza más alto a las imágenes fake que a las reales. Nos fiábamos más de los sujetos generados por Inteligencia Artificial. En resumen, nuestra percepción está muy lejos de ser certera en la detección de imágenes fake y, como añadido, hay una serie de características de estas imágenes falsas que nos invitan a confiar más.

Fuente: De las 4 personas más «confiables» (arriba), 3 eran sintéticas y 1 real. Las 4 menos confiables (abajo) eran reales

Comenzábamos hablando sobre la falsedad de las imágenes que han circulado de Putin y Zelensky. No parece lógico que redes como Meta se apunten un gran tanto con su detección porque son ejemplos verdaderamente malos de tecnología Deep Fake. Esa es la realidad. O la falsedad, mejor dicho. Pero a partir de aquí surgen importantes incógnitas. Tenemos que tener en cuenta que hay una importante parte del mundo a la que no llega el conocimiento de esta tecnología y, mucho menos, el debate que se genera alrededor. Son países y poblaciones a las que llega una imagen, a todas luces verdadera, y a las que su nivel de tecnología, conocimiento, criterio, etc. no les permite ni vislumbrar que pueda haber un engaño tras ese rostro. Y luego, lo que ya comentábamos. El caso de los falsos presidentes era bastante fácil de detectar, pero, obviamente, esta tecnología camina hacia todo lo contrario. Está muy cerca ese punto en el que pueda resultar algo indetectable a los ojos de la población (quizá ya estamos ahí) y esto nos sitúa ante un escenario que se antoja bastante complicado.

En las conclusiones del estudio, la Dra. Nightingale advierte de los peligros de una tecnología que está al alcance de cualquiera. De hecho, hay una clara invitación a la creación de pautas de autorregulación e incluso animan a los desarrolladores de dichas tecnologías a sopesar si los riesgos asociados a las mismas son mayores que sus beneficios.

Fuente: Arriba, los más certeramente clasificados, como reales y sintéticos, y abajo, los menos.

Pero hay más aristas. El Deep Fake se está utilizando como medio de extorsión y fraude. Según un estudio del Crime Science Journal, los deepfakes con propósito criminal son el delito basado en inteligencia artificial con capacidad de daño o lucro de su ámbito y los más difíciles de combatir. Hablamos de secuestros falsos mediante la imitación de voz o imagen en video, de imitación por voz para acceder a sistemas seguros y una numerosa gama de extorsiones con videos falsos, en multitud de ocasiones, de contenido sexual.

Por otro lado, Nina Schick, autora del libro Deepfakes, considera que en ese futuro cercano en el que nos encontremos ante ejemplos “indetectables” de esta tecnología, llegará la erosión de la confianza en los medios auténticos ya que va en aumento la creencia de que todo puede ser falsificado. Y, desde luego, no resulta especialmente alentador pensar en ese momento en el que, verdaderamente, no podamos distinguir lo verdadero de lo falso y no sepamos qué creer.

También en nubbitel.es

Descifrando los estándares WiFi: 4, 5 y 6. Te contamos todo lo que te interesa

En el mundo de la conectividad inalámbrica, los estándares WiFi juegan un papel crucial en determinar la velocidad, el alcance y la eficiencia de nuestras redes. Con el tiempo, hemos visto la evolución de estos estándares, y en la actualidad, destacan el WiFi 4, WiFi...

Internet vía satélite: el retardo

Para concluir nuestro repaso por las diferentes alternativas de acceso a internet que tenemos en las zonas en las que la fibra óptica no es una buena opción o, simplemente, no es una opción (pueblos sin despliegue, parcelas, fincas…) hoy queremos hablarte de una de...

Internet 4G. ¿Es suficiente?

Hace unos días te hablábamos del WIMAX, un sistema altamente fiable y estable que estaría a la cabeza de las soluciones de conexión a internet fuera de la ciudad. Es cierto que las conexiones de fibra van ganando terreno en nuestros pueblos, pero en ellos y,...

Queremos que estés cerca, sentirte, escucharte, leerte, interactuar contigo, compartir…